产品展示

- 发布日期:2024-11-18 18:22 点击次数:96

图源:pixabay

撰文 | 施郁

01

导言

2024年诺贝尔物理学奖授予霍普菲尔德(John J. Hopfield)和辛顿(Geoffrey E. Hinton),奖励他们“关于导致机器学习的人工神经网络的基础发现和发明“,他们“用来自物理学的工具发展了成为今日强大的机器学习的基础的方法。霍普菲尔德创造了联想记忆,能够存储和重建图像和数据中的其他模式。辛顿发明了一个方法,能够自动寻找数据中的性质,从而进行确认图片中的特殊元素的任务。” [1-3]。

不少评论认为,这次物理学奖发得不合适,甚至戏称,物理学不存在了。

恰恰相反,我认为,这个奖发得非常好,但是作为物理学最高奖,颁奖词对获奖工作的物理学意义强调不够。虽然《通俗背景》和《科学背景》文本里都介绍了与物理学的关系,但是新闻报道和大多数人关注的依据主要是颁奖词。在《科学背景》中,提到霍普菲尔德之前是生物物理的重要人物,却忽略了更早期,他对凝聚态物理有重要贡献,获得过该领域最高奖巴克利奖,他近年还当过美国物理学会主席。当然,这些都不是获物理学奖的理由。

我认为,获物理奖的理由是,获奖工作(特别是霍普菲尔德的工作)就是物理学工作,而不仅仅是物理学方法的借用。物质世界有各种层次,从无生命物质到生命物质,从无智能到有智能。在理解智能的道路上,有一个节点是联想记忆功能。联想记忆和智能代表物理系统到达某个层次后所具有的性质。霍普菲尔德提出了联想记忆的物理机制,用动力学实现联想记忆功能,提出一个具有联想记忆功能的模型,即霍普菲尔德神经网络模型。辛顿与霍普菲尔德的学生Terrence Sejnowski以及合作者发明的方法基于玻尔兹曼统计分布,相当于有限温度下的霍普菲尔德模型,与近年机器学习的突飞猛进直接相关。

诺贝尔颁奖词强调,这里既有发现,也有发明。我理解:“发现”是指发现一个物理规律,即联想记忆的物理机制;“发明”是指设计建构人工神经网络。他们用物理学的理论方法发展了人工神经网络,导致机器学习,在目前的人工智能中占了很大成分。

我还要补充,这也对脑功能研究作出贡献,用物理学(特别是统计物理和凝聚态物理)的方法,基于脑功能的部分要点,构造新的计算原理,提出联想记忆的物理机制,这个物理规律给出对这部分脑功能的理解,而人工神经网络验证了这个规律。尽管人工智能后来“放飞自我“,并不以研究人的智能为主要目的,但是最初是源于这个动机。

人工神经网络也因应了计算机科学的发展需要。1940年代,电子计算机诞生,帮助了核武器研制和各种科学计算。1950年代,数学家和计算机科学家发展基于逻辑规则的计算机程序,但是对于图像分类这样的任务,计算资源不够。人们希望计算机能够进行模式识别,促进了人工神经网络和人工智能的兴起。

这更是统计物理和层展论的胜利。层展论是说,系统的规律不是组分的个体性质,例如,大量粒子的聚集物的行为,并不是少量粒子的性质的外推。霍普菲尔德为了理解大脑,在统计物理和层展论的思想框架中,提出并回答了 “物理系统如何获得联想记忆的功能” 这个问题[4],指出这个功能是计算能力,即联想记忆是图灵可计算的,而且是在物理系统中层展出的合作行为。我认为,这是诺贝尔物理学奖授予这个成就的根本原因。

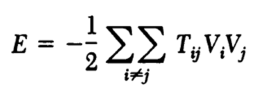

霍普菲尔德模仿大脑,在一个大量基元耦合的多体模型,即霍普菲尔德模型中,实现联想记忆功能,也指出这个模型与自旋玻璃的关系,联想记忆等效于在崎岖能量景观中寻找能量极小值。神经网络被提供线索(部分或有偏差的信息)后,不断降低能量,找到最接近的储存信息[4]。

将思维和意识等脑功能看成机器的功能有非常长的历史,也是唯物主义哲学的观点,计算机的兴起强化了这点。生物学、生理学和心理学积累了关于大脑和认知的知识,而统计物理和层展论带来思想和方法的提升。霍普菲尔德模型也开启了计算神经科学,人工神经网络与神经科学互相促进。

辛顿、Terrence Sejnowski和合作者在霍普菲尔德模型基础上,利用统计物理的玻尔兹曼概率统计,叫做玻尔兹曼机,用工作时可能出现的例子进行训练,从而能够从某种数据中辨认出特征[5,6]。玻尔兹曼机可以对图像进行分类或者创造出与学习过的例子相近的图像。机器学习突破了通常的指令式的计算机软件,使用整个网络,通过对例子的学习,获得处理更复杂问题的能力。

霍普菲尔德和辛顿的开创性工作和关键性贡献最终导致人工智能的巨大发展,后者促成前者得到诺贝尔奖的认可,也对物理学和整个科学研究产生深远影响。

人工神经网络是物理学进入生命、智能和计算领域的代表性成果,是三个学科传统汇集的产物。神经生物学启发了人工神经网络的基本要素,所以人工神经网络的成功说明,至少一部分的脑功能确实是复杂系统的层展行为。虽然神经网络和机器学习后来走向更实用的方向,但是奠基性工作是来自统计物理。神经网络的成功是统计物理、层展论、神经生物学和数学物理的共同胜利。

诺贝尔物理学奖对这个领域的肯定,也认可了对物理学更宽广的理解,即物理系统的基本单元可以是新的层次上的,可以是自然的,也可以是人工的,例如生物或人工的神经元。某种意义上,物理学家做的研究就是物理学。关于生命和计算的物理学,正越来越多地被视为物理学主流的一部分。这些研究内容早已在物理学会议中占据很大成分。例如,长期以来,国际理论物理中心时常有神经计算方面的学术活动,2001年,该中心授予霍普菲尔德狄拉克奖章,因为他“非常宽广的贡献,包括嗅觉原理和利用神经元通讯尖峰时间结构的神经功能”;国际纯粹与应用物理联合会的两三年一次的统计物理会议中,神经网络是主题之一,在2023年会议上,霍普菲尔德“因为扩展了统计物理的边界,使之囊括生命现象,从分子水平的信息传输到创建了一个思考大脑中计算的新语言的神经网络动力学“,分享2022年玻尔兹曼奖。

2020年彭罗斯获得诺贝尔奖后,我说这是诺贝尔奖的突破:“本次诺奖也可算是首次颁发给数学物理,或者理论物理中与实验联系不具体、不直接的方面。诺奖对这些领域的态度变得更友好。这些领域……关心的问题、研究的风格和方法,乃至价值标准都有所不同。彭罗斯的工作属于与天体物理相关的引力理论,类似的领域,还有与凝聚态物理相关的统计物理,与粒子物理相关的量子场论,等等。传统来说,它们的成果显然不容易获得诺奖。物理诺奖的新时代开始了。”[7] 长期以来,诺贝尔物理学奖主要覆盖粒子物理、凝聚态物理、原子分子光物理和天体物理。现在,更多物理学领域开始被诺贝尔奖眷顾。希望将来也覆盖流体力学这种从物理学独立出去的传统领域。

2021年Giorgio Parisi等人的复杂系统研究和今年神经网络研究正是统计物理方面,证实了我的判断。去年霍普菲尔德获玻尔兹曼奖后,我还和他的一位学生说到,他本来也可与Parisi分享诺奖,将来也可能得。

02

生物学源泉

诺贝尔物理学奖授予神经网络和机器学习的成就,使得物理学和计算机科学的交叉成为关注焦点。然而追根溯源,它们建立在神经科学的奠基性工作上,而神经科学从一开始就是生物学与物理学的交叉。诺贝尔奖官方资料只提到直接相关的Warren MacCulloch和Walter Pitts以及Donald Hebb的工作,下面我们先补充回顾其他相关生物学工作。

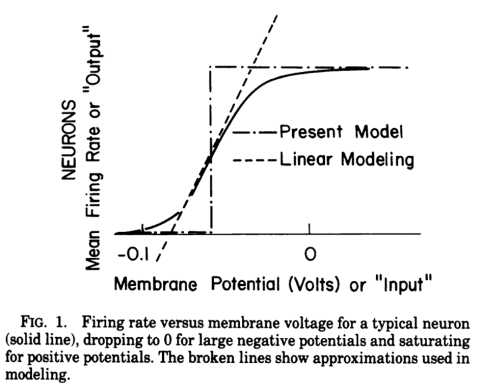

18世纪后期,Luigi Galvani发现,电刺激引起青蛙腿抽搐,开启了电生理学。19世纪中叶,Emil du Bois-Reymond和Julius Bernstein证明了神经信号是电信号,Bernstein也发现了神经元的动作电位(激发和静息状态的电压差)。20世纪初,Santiago Ramón y Cajal用Camillo Golgi的染色技术,发现神经系统由大量神经元(即神经细胞)组成,两人分享1906年诺贝尔奖生理学或医学奖。1906年,Ivan Pavlov的条件反射工作开启了实验心理学。1910年代, Louis Lapicque写下神经传导的等效电路方程,发现神经元的膜电压到达一定阈值就导致激发(图1)。1920年代,Edgar Adrian注意到神经元状态要么激发要么静息(all or none)。这个二值性让我们想到比特或者自旋,历史上也确实有此发展,导致本次诺贝尔物理学奖的成就。

图1 神经元的膜电压。图源:文献[4]。

一个神经元的轴突(axon)末梢经过多次分支,最后每一小支的末端变大,呈杯状或球状,叫做突触小体,可与其他神经元的细胞体或树突(dendrite)相联结,形成突触(synapse),这是一个小的缝隙,轴突向树突或细胞体传送递质或电信号。所以,突触是神经元之间在功能上发生联系的部位,也是信息传递的关键部位。

1943年,MacCulloch和Pitts发表《基于关于神经活动的想法的逻辑代数(A Logical Calculus of Ideas Immanent in Nervous Activity)》[8],试图找到逻辑和思考的生理学和物理学基础。他们指出每个神经元通过突触接受来自其他神经元的信号,当输入达到一定的阈值,就产生输出信号,输入和输出都由电压代表。这是当时神经生物学实验结果和假说的混合。基于神经元状态的二值性,他们提出可以用来实现布尔代数,构造逻辑线路,也讨论了计算理论问题。这可以说是第一个神经网络模型,将大脑活动与计算机具体联系起来,给出心身关系或者“意识是物质的功能”之说的具体模型。

他们的文章以数学风格写出,3篇参考文献都是数理逻辑著作:卡尔纳普的《语言的逻辑句法》、希尔伯特和Ackermann的《数理逻辑基础》、罗素和怀特海的《数学原理》。MacCulloch是对数理逻辑感兴趣的生理学家,相信神经活动与计算和逻辑有对应关系,但是缺乏数学能力。18岁的Pitts数学强,是卡尔纳普的非正式学生(12岁时向罗素指出《数学原理》中的错,15岁到芝加哥大学听罗素的演讲,滞留在那里,又告诉该校的卡尔纳普《语言的逻辑句法》中的错)。战后,维纳(Norbert Wiener,控制论创立者)和冯诺依曼(John von Neumann)等应用数学家对他们的工作很感兴趣,他们也都成为维纳的合作者、控制论的先驱。信息论、控制论和认知科学兴起,将大脑看成计算机,神经网络强化了这种思想。

1949年,加拿大心理学家Donald Hebb出版《行为的组织》,企图将心理学归结于生物学,将意识和记忆归结为力学过程,提出学习和记忆的一个机制,后来叫做Hebb学习律:两个神经元的同时激发加强突触强度[9]。在此之前,Jerzy Konorski也曾经发表类似的观点[10]。

Hebb学习律意味着,一个神经元再激发时,与之联结的神经元就容易被激发。因此神经元状态决定联结,联结又决定神经元状态。从这里已经可以看到联想记忆的成分。Hebb学习律提出时的猜想成分很大,因为数据有限,但是后来得到很多实验验证,现在更得到分子生物学支持。1970年,Eric Kandel发现,海蛇学习时,化学信号改变突触结构,而且短期和长期记忆由不同的信号产生,因此获2000年诺贝尔生理学或医学奖。1999年,一个研究组对老鼠的据信接受突触信号的受体蛋白进行转基因,发现它的超表达导致学习能力增强[11]。下面我将提到,著名理论物理学家列昂•库珀(Leon Cooper)转到神经科学后,主要的工作就是关于突触的可塑性。

1952年,Alan Hodgkin和 Andrew Huxley(Thomas Henry Huxley之孙)揭示动作电位的离子机制,方程中包括电流向内的钠离子通道、电流向外的钾离子通道和其他离子流, 1964年获诺贝尔生理学或医学奖。1957年,Wilfrid Rall揭示,树突影响神经细胞的电性质。

‘

03

早期人工神经网络

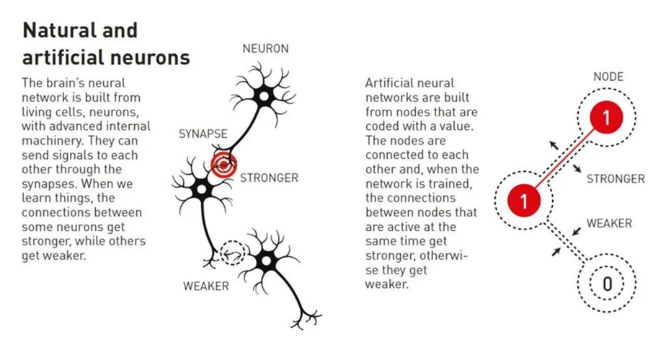

1957年,冯诺依曼在他的《The Mind and The Brains (意识与大脑)》中,指出神经网络与串行计算机相距甚远。人工神经网络是对生物神经系统的模仿(图2)。每个节点模仿一个神经元,可以取不同的值,简单起见,就是0或者1,或者-1和+1。节点之间有联结,互相影响;联结模仿生物神经元的突触,也可以取不同的值。人工神经网络有递归和前馈两种结构。在递归网络中,每个节点的状态由其他节点的状态决定,可以有反馈,因此每个节点的状态既是输出,也是输入,联结可以组成回路。而前馈网络有输入和输出层,也可以有隐藏层。

图2 左边是大脑神经网络的神经元和突触,右边是人工神经网络的节点和联结。图源:[2]。

第一个作为真实机器的人工神经网络是1957年美国康奈尔航空实验室Frank Rosenblatt建造的“感知器”。这是一个前馈网络,信号通过一个摄像机到达网络的输入层,输入层和输出层之间有可变联结[12]。神经网络只有两层,如果算上摄像机,也被说成3层。Rosenblatt宣称它会犯错误,但是将像人一样思考,在经验中成长。它的学习功能基于惩罚机制:如果将输出0弄错成1,减弱神经元到输出单元的联结;如果将输出1弄错成0,则加强这个联结。这也激发了神经科学的联结主义,认为脑功能也像感知机一样,从联结中涌现出。1960年,斯坦福大学的E. Widrow建造了一个类似的机器Adaline (Adaptive Linear Neuron)。

1969年,Marvin Minsky和Seymour Papert出版了《感知机》[13],从数学上严格探讨感知机,但是注意到感知机的局限性,例如,它不能处理“异或“(A或者B,但是不能都是)这样的非线性问题。这导致人工神经网络研究进入低潮,甚至被称为联结主义的黑暗时代,沉睡了10年多。这是反应过度,感知机是可以改进的,异或问题可以通过增加额外层来解决,也可以采取不同的学习律,例如Hebb学习律。事实上,D. Willshaw, O. Buneman和H. Longuet-Higgins在1969年,以及后来T. Kohonen,建议回到Hebb学习律,并讨论了联想记忆[14]。

另一方面,从1950年代到1970年代,一直有物理学家在理论上构造类似磁性系统的递归神经网络,研究其合作性质。例如,1954年,B. Cragg和H. Temperley首先将铁磁性这样的合作现象与记忆相类比,将冯诺依曼提出的记忆池概念物理化[15];1961年,E. Caianello讨论了思考过程和思考机器[16];1972年,K. Nakano提出一个具有联想记忆功能的“联想机”[17]; 1972年,甘利俊一(Shun-ichi Amari)提出一个有阈值元素的自组织网络模型,具有学习、联想记忆、概念形成和信息处理功能[18];1974年,W. A. Little引入噪声,用自旋模型的相变解释记忆[19,20],这些工作应视为霍普菲尔德模型的先驱。

统计物理用微观相互作用解释宏观性质。看来用统计物理理解脑功能是1950年代后一批物理学家的希冀。我曾经写过[21]:“1971年杨振宁给著名的20卷丛书《相变与临界现象(Phase Transitions and Critical Phenomena)》(Domb 和Green 编,1971-2001)的第一卷写序,最后一段提到统计力学与脑功能的关系:“今后几十年的一个重大智力挑战是脑组织的问题.记忆存储的基本机制是什么? 什么过程实现体内基本上化学的过程与大脑的很特定、非统计的操作之间的联系? 最重要的,人脑如何实现概念的形成? 我疑惑,是不是这些研究中的物理学精神与感动‘热力学的合理基础’奠基者的并不相似.” 在这个方向上,Little的文章发表于1974年,Hopfield的文章发表于1982年。”

04

联想记忆与霍普菲尔德模型

1979年到1980年期间,霍普菲尔德开始对神经网络感兴趣。1982年,他用统计物理的方法和层展论的理念,集相关工作之大成,将联想记忆描述为一个动力学吸引子,展示了如何从部分信息出发,神经网络状态在自旋玻璃的崎岖能量景观上演化到局域基态,得到整个记忆[4]。作为理论研究的策略,他采用并不符合生物学情况的对称联结,使得基于McCulloch-Pitts模型的神经网络映射到自旋模型;采用Hebb学习律实现了内容可寻址的联想记忆;而且也实现其他脑功能,例如模式识别。他基于模拟,猜想N个神经元通过N(N-1)/2个对称联结就能记住N/6比特的信息(局域稳定的自旋位形),为后来的理论所证明。

霍普菲尔德模型是在层展论思想下的主动实践。这可以从他1982年论文的标题和摘要看出[4]。标题是:“具有层展合作计算能力的神经网络和物理系统。”摘要是:“对于生物组织或者计算机建造有用的计算性质能够作为具有大量简单等效成分(或神经元)的系统的合作性质涌现出来。内容可寻址的记忆的物理意义用系统状态的合适相空间流来描述。我们提出这种系统的一个模型,它基于神经生物学的特性,但是可以用于集成电路。这个模型的合作性质产生内容可寻址的记忆,它可以从任何大小足够的部分恢复所有记忆。系统状态的时间演化的算法基于不同步的并行处理。其他的层展合作性质包括一些可以推广的能力,熟悉辨认、分类、纠错,和时间序列保持。合作性质只对模型细节或者个别设备故障微弱敏感。”

他细化了联想记忆的概念:根据部分信息(甚至是有偏差的信息),利用相似性寻找正确的目标。这里的一个重要思想是,联想记忆不是单个神经元的性质,而是整个网络的性质。

他的问题是:大量神经元的层展合作现象能否给出计算能力?他用到MacCulloch-Pitts和Hebb规则,借鉴描写物质磁性的格点自旋模型(格点上,相邻自旋有耦合),特别是自旋玻璃模型(自旋之间的耦合是无序的),基于一个递推神经网络模型,提出联想记忆的动力学模型。霍普菲尔德模型复兴了神经网络。

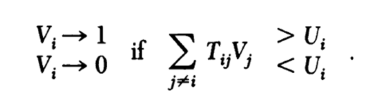

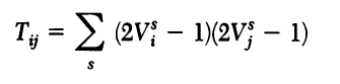

霍普菲尔德神经网络是一个递推模型,每个神经元的状态决定于网络中其他神经元的状态,每个信号的输入要乘以一个参数,代表突触权重,所以来自不同神经元的信号的加权求和代表总的输入,用来与阈值相比比较,MacCulloch-Pitts规则表达为:

神经元的状态Vi 据此更新。这类似于铁磁模型中的分子场。联结强度按照Hebb学习律变化,

这里的平均是对历史的平均,也就是说可以将多个记忆累加到联结上。

霍普菲尔德考虑对称的联结强度(权重因子),取决于欲存储的状态

这样可以保证系统演化到动力学吸引子。他发现

在以上的算法中单调下降,直到局域极低。这在数学上叫做李雅普诺夫函数,类似于自旋的伊辛模型的能量函数。如果联结取值具有随机性,就是自旋玻璃模型。

联结强度对称的意思是,某个神经元的轴突向另一个神经元的树突传送递质或信号的性质等于后者的轴突向前者的树突传授递质或信号的性质。这在生物学上是没有理由的,所以是为了研究方便所做的假设。对称联结使得一些生物学家觉得与生物学实际情况无关。但是后来物理学家发现,统计物理也能处理非对称联结。作为物理学的常见处理方式,可解的简化模型可以反映与实际系统的共性。霍普菲尔德用几十到100个神经元,做了蒙特卡洛模拟,观测到各种终态,包括稳定态,循环态和混沌态,并研究了记忆恢复的细节。

能量函数描写整个网络系统,依赖于所有神经元和联结的取值。训练时,信息输入到神经元,取0或1(或者正负1),然后调整联结的取值,使得存储信息对应的能量较低。这还可以存储多条信息载体。系统能量有很多极小值。工作时,如果将部分信息提供给神经网络。网络得到输入信息后,调整神经元的状态(即节点取值),使得能量降低,到达附近的极小值,这样恢复最接近的存储信息。所以联想记忆就是在能量景观中,寻找能量局域极低点的过程。

这就好比在崎岖不平的景观上滚球,摩擦力使得球滚得很慢。球滚到附近较低的谷。因此霍普菲尔德网络可以用来恢复数据,也提供了纠错的方法,因为纠正以后状态处于能量极低。霍普菲尔德还简单讨论了非对称联结导致的亚稳态。

图3 联想记忆示意图。图源:文献[2]。

我们可以打一个比喻,学习过程中确定联结值,从而存储信息,相当于量身做衣,存入衣库;获取存储信息相当于根据一部分体型信息,在衣库中找到最合身的衣服,从而确定准确的体型信息。

神经元状态一致,则联结加强;状态相反,则联结减弱(后者不是Hebb原先的观点,但是后来的实验表明了这点)。这导致共同激发的神经元联在一起。基于Hebb学习律,霍普菲尔德模型可以存储多个记忆,用动力学吸引子(极低能量态)和吸引盆解释了联想记忆,使得部分信息可以用以恢复整个记忆。而联结的随机性通过自旋玻璃理论,正好导致具有这些性质的崎岖景观(有很多亚稳态)。这些元素拼成一个完美融洽的图像。

霍普菲尔德在文章最后,一方面指出,高级神经系统的计算功能可能从大量单元的合作行为中自发层展出来,另一方面也建议用集成电路实现他的模型。

下面我们看看此文的参考文献。论文一开头就引用了3篇生物学背景论文,说明霍普菲尔德当时的动机是理解大脑功能。然后说“本文检查一个关于这个古老而基本的问题的一个新的建模”,引用了5篇前人的建模,包括甘利俊一和Little的工作。接着谈到神经系统的细节还不清楚,引用了J. Marr。提到计算机中的可寻址记忆和纠错时,引用了T. Kohonen和G. Palm。介绍自己的模型时,引用了 McCulloch-Pitts。与感知机比较,引用了Minsky-Papert和Rosenblatt。

用两个神经元存储状态的乘积给出联结时,引用了库珀1973年的两篇文章,其中一篇文章发表于关于“物理系统的合作性质“的诺贝尔研讨会文集(我后面还要谈到这个会议)[22],一篇是与他人合作的期刊文章,库珀用状态乘积给出联结的改变。不过,类似的表达式在甘利俊一的文章里已经有了。霍普菲尔德指出,类似的联结也用在之前的线性联想网络的理论中,包括库珀的文章,还有Longuet-Higgins的两篇关于记忆的文章,以及Kohonen关于联想记忆的书。他还评论,线性网络要与外部处理器联结(引用了两篇神经网络文献),而他的模型的性质不是来自线路的复杂性,而是来自大量神经元。接着,他与生物学做了一些对比,引用了3篇文献。又与Little、Shaw和Roney的模型对比,指出与他们的模型中,不同神经元激发之间的时间差很重要。在引入学习规则时,引用了Hebb的书和J. G. Eccles的书。指出联结是对称但随机,系统有很多稳定态,这里引用Kirkpatrick和 Sherrington的自旋玻璃论文。做数值模拟时,选取神经元数量是100,因为脑神经元数量通常是100到10000,依据是3篇生物学文献,包括Kandel在《科学美国人》上的文章。

库珀和Longuet-Higgins都是理论物理学家。结合前面杨振宁的话,说明那时有一批物理学家对脑感兴趣。库珀是超导BCS理论的作者之一,提出库珀对的概念,1972年与巴丁(B)和施瑞佛(S)分享了诺贝尔物理学奖。他1960年代末研究过量子力学基本问题,后转到神经科学。他在霍普菲尔德引用的关于突触改变的工作之后,又继续研究,1982年和学生提出,突触接近饱和时,联结的有效性降低,从而又降低饱和度,这叫BCM理论,后来又提出突触改变的机制[23]。Longuet-Higgins本来研究分子物理和化学,1963年和Herzberg在分子中发现几何相位,后来兴趣转到大脑和人工智能,从剑桥大学转到爱丁堡大学。希格斯是他在伦敦国王学院的学生,1954年博士毕业。1977年,在爱丁堡,辛顿在他指导下因视觉研究获博士学位。所以霍普菲尔德的模型受益于Longuet-Higgins的工作,后来两人的学生辛顿和Sejnowski的合作工作受益于霍普菲尔德模型。

最初霍普菲尔德模型储存的记忆有限,后来得到提高[24]。特别是,自旋玻璃理论专家Daniel Amit,Hanoch Gutfreund和Haim Sompolinsky [25], 以及M. Mezard, Parisi和M. Virasoro[26],用自旋玻璃的理论方法,解析推导出储存量等基本性质。下一章我们专门介绍自旋玻璃。

霍普菲尔德本人还论证了二值神经元和分立时间可以取代为连续变量和连续时间[27],又和D. Tank用连续时间和连续变量解决了分立优化问题[28,29]。1994年,霍普菲尔德还与合作者提出,神经网络中有自组织临界[30,31]。自组织临界是汤超和合作者提出的非平衡系统的一个概念,最初用沙堆模型[32]。(我学生时代曾注意到神经网络和沙堆模型的规则中都有阈值,猜想神经网络中也许有自组织临界,但是没有深入研究。)

05

自旋玻璃

层展论是霍普菲尔德神经网络工作的指导思想,霍普菲尔德的工作也受益于与安德森(P. W. Anderson)的长期密切交流[33,34]。安德森是层展论和凝聚态物理的精神领袖 [35,36],他1972年的散文《多了就是不一样(More is different)》是层展论的宣言[37]。凝聚态物理和统计物理有很大重叠性,凝聚态物理更侧重具体的凝聚态系统,统计物理更侧重一般性理论,但是二者在很多方面区分模糊,有时合称凝聚态与统计物理。

安德森也是自旋玻璃的代表人物[35]。起源于磁性杂质和磁性合金,自旋玻璃问题从凝聚体物理的难题发展为复杂系统和统计物理的一个范式,用于优化、神经网络、蛋白质折叠、生物演化等等,也是数学物理问题。一个格子上,每个格点上有一个自旋,相邻自旋有耦合能量,等于一个耦合系数乘以两个自旋值。这是伊辛模型。如果耦合系数有随机性,就是自旋玻璃。

1974-1975年,在剑桥大学卡文迪许实验室,Sam Edwards和安德森考虑耦合系数的概率分布是高斯函数,提出复制方法,将随机平均转化为复本问题,再取复本数趋于零的极限(因为一个数学等式),给出一个平均场理论。

这个方法立即被David Sherrington(Edwards的已毕业学生、当时在帝国理工)和IBM的Scott Kirkpatrick用到每个自旋与所有其他自旋耦合的情况,导致一个荒谬结果:零温下的熵是负数(熵不可能是负数)。这就是霍普菲尔德1982年文章引用的工作。

David Thouless(2016年因凝聚态中的拓扑获诺奖)、安德森和学生R. Palmer(TAP)用Lars Onsager和Hans Bethe的处理伊辛模型的方法,找到了合理的解,解决了负熵问题。但是Palmer和Kirkpatrick都在数值计算中注意到存在很多亚稳态。Thouless和学生Jairo de Almeida发现温度低于某个临界值时,复本之间的关联不再是统一的,即复制对称破缺。Gérard Toulouse注意到自旋玻璃的主要特征是阻挫:因为自旋耦合符号的随机性,自旋之间的耦合能量不可能都最低。“阻挫”一词来自安德森。

Parisi也考虑高斯分布的耦合系数,提出复本对称破缺的理论,解决了难题。他给出了复本之间的关联,是复本理论的自洽稳定解,表明在某个临界温度之下, TAP平均场方程(即伊辛模型的平均场方程,但是耦合是随机的)并没有唯一的局域稳定解,而是有很多解,每个解对应一个复本,复本关联代表它们之间的相似度,各种关联形成一个等级结构,叫做超度规。Parisi很大程度因为这个工作,分享了2021年诺贝尔物理学奖。

人们意识到,自旋玻璃模型可以用于很多复杂系统。Kirkpatrik和学生Daniel Gelatt提出模拟退火算法,计算成本相当于能量函数,再与随机采样的Metropolis算法结合起来。Miguel Virasoro证明能量越低,则临界温度附近熵越大,也就是说,越有机会到达能量极低状态。安德森更感兴趣将自旋玻璃理论用到复杂系统。他和学生傅曜天(1980年从上海师范学院考取CUSPEA)、Wuwell Liao将此用到图的拆分问题,这是一个NP完备问题。

安德森高度评价霍普菲尔德的神经网络工作[34]。安德森说,对于霍普菲尔德的成就的每一个方面,都有神经科学家和计算机科学家声称先前已有工作,但是霍普菲尔德模型导致了神经网络后来的发展,而且有可靠的数学基础,导致对功能和准确性的严格数学证明, 比如Gérard Toulouse, Haim Sompolinsky, Miguel Virasoro, John Hertz, Richard Palmer等人的工作。

1981年,安德森去加州理工参与霍普菲尔德、费曼、Mead的信息物理课程帮忙,受霍普菲尔德神经网络工作的启发,安德森想到将自旋玻璃的崎岖景观用到生命起源,和学生Daniel Rokhsar, Daniel Stein研究了这个问题。Stuart Kauffman将此想法推广到各种生物演化问题,Gerard Weisbuch指出这些演化中存在间断平衡。

06

霍普菲尔德的道路

以及与安德森的互动

霍普菲尔德的父母也都是物理学家,这深刻地影响了他[33,34]。父亲和他同名,也是John Joseph Hopfield,从事光谱学,师从后来长期执掌伯克利加州大学物理系的Raymond Thayer Birge。小霍普菲尔德在Swarthmore学院念本科,他的兴趣在于固体物理,选择去康奈尔大学读研。导师Albert W. Overhauser曾经提出在微波场中,顺磁金属中电子自旋极化可以导致原子核的极化,这个反直觉的效应被称为Overhauser效应。霍普菲尔德1958年博士毕业,博士论文是关于激子对介电常数的影响。他将极化场的准粒子(光子和声子的混合)起名为极化激元(polariton),也被称为霍普菲尔德电介质。他这篇论文至今还很有影响。

我研究生时期读过霍普菲尔德1982年文章,一直记得他讨论联想记忆时,所用例子是Kramers和Wannier关于伊辛模型的名作的作者和期刊信息。这反映了他的学科背景是凝聚态理论和统计物理,学术经历与库珀和Longuet-Higgins颇有类似。

霍普菲尔德博士毕业后在贝尔实验室理论组工作了两年,安德森是这里的资深同事,当时刚刚完成后来1977年获诺贝尔物理学奖的无序导致局域化的理论。霍普菲尔德与实验家D. G. Thomas合作研究硫化镉的光学性质。1969年,因为这项“光与物质相互作用的理论和实验”,两人同获美国物理学会的巴克利奖(被视为凝聚态物理专业最高奖)。1960年,霍普菲尔德加入伯克利加州大学。1964年,加入普林斯顿大学物理系。

霍普菲尔德崇尚鲍林(Linus Pauling)所说的,要经常问自己“能否对所研究的问题有所贡献”。1968年他觉得,凝聚态物理中,自己的才能能够发挥作用的问题没了,于是用古根海姆奖金去卡文迪许实验室待了半年(多年以前他父亲曾经以同样的奖金去同样的目的地)。在这里与老同事安德森会合了。

1967-1975年,安德森是剑桥大学卡文迪许实验室兼职教授,每年有一半时间在这里。1968-1969年,他与剑桥的学生Gideon Yuval和贝尔实验室的博士后Don Hamann用重整化群研究近藤问题,这是固体理论的重要工作。他们在论文中感谢霍普菲尔德的讨论、建议和告知未发表工作。安德森在他1994年的论文集中说,霍普菲尔德是这个工作的隐藏合作者,并提到,霍普菲尔德那年在剑桥[34]。论文是1969年收稿.。由此判断,这正是霍普菲尔德受古根海姆奖金资助的那次。

霍普菲尔德从剑桥回到普林斯顿后,在贝尔实验室碰到Robert Shulman,他在做血红蛋白的实验。于是开始血红蛋白研究,提出一个理论,描写血红蛋白分子合作行为以及与动理学和结构的关系。他还继续做一点凝聚态物理工作,1973年,他与William Tapp合作,提出电子结构计算方面的内积守恒赝势法。

前面我们提到,霍普菲尔德1982年文章引用了库珀1973年在“物理系统的合作性质“的诺贝尔研讨会上的神经科学报告。霍普菲尔德本人也参加了此次物理会议,报告了他当时的血红蛋白研究。

霍普菲尔德本人没有提过这件事,但是我觉得,与同为凝聚态理论物理学家、当时已经转入神经科学的库珀(前一年刚获诺奖)交流,或许为他几年后的类似转变起了作用。而且为这次会议做总结报告的,正是安德森(上面我们已经展示他对霍普菲尔德的影响),其中有一段话支持本文所说,统计物理和层展论对神经科学和神经网络发挥了重要作用,翻译如下:“我们也有一个走出我们领域的未来,正如Harry Suhl、列昂•库珀和约翰•霍普菲尔德富有才能地显示给我们的。所有这些报告说明,为什么多体理论家能够而且应该进入科学更广的领域,为什么他们能够做得如此之好。我认为我们是独特的物理学家,在方法上不拘一格,在观点上不拘一格。我们不是不愿意从最抽象的数学层次上吸收方法和想法,正如有几篇文章显然说明的(我肯定在某些地方没听懂)。我们很多人也完全不是不愿意弄脏手,不仅研究现象,而且研究跑来跑去的电子和原子,用某种技术,深入进去搞懂。如果这只是将动理学做对,而不是文献上不可思议的乱七八糟,那就是我们至少能做的……如果我们和霍普菲尔德一样好……某个本来没有做好,直到多体理论家转到那个领域。所以我们有个好的领域在做。我们也有很好的机会转出本来的领域,看看更宽广的东西,特别是对于比我年轻的人来说。我认为我们必须认为我们是幸运的。” 这里提到的“多体理论”是凝聚态物理的重点和难点,有时也包括核物理等其他领域的多体问题。霍普菲尔德后来的神经网络工作正好应验了安德森的话。

当时,霍普菲尔德寻找以自己的背景可以解决的生物学问题。他注意到功能这个概念是生物学独有的。1974年,他开了一门生物物理课, 其中覆盖了细胞膜的电子转移、神经脉冲沿轴突传导的Hodgkin-Huxley方程,这成了他神经生物学的知识基础。为了上课内容的需要,他还自己想出了两个问题, 一个是生物分子中的电子转移,这是最简单的化学反应(因为不改变化学键),例如光合作用的早期阶段。第二个问题是细胞中蛋白质合成的生化反应中的纠错机制,即动理学校正,解释了DNA复制的准确性。这项工作受到了Overhauser效应的方法论启示,因为两者都需要与能量源耦合。这还导致他思考生物学中网络的功能,而不是生物分子结构的功能。网络具有单个分子所没有的功能。6年之后,他将此思想用到神经网络。

1975年,安德森希望结束在剑桥的兼职,于是在霍普菲尔德的努力下,换成在普林斯顿兼职[34,38]。当时霍普菲尔德是唯一的凝聚态理论教授。安德森的学生Palmer是助理教授(两年后离开)。

1977年,他参加了一个神经科学讨论组。组织者Francis O. Schmidt认为科学终究要填上分子、脑、意识和行为之间的鸿沟,想找一个物理学家参加,并不介意其懂不懂神经科学。Schmidt找惠勒(John Wheeler)推荐,惠勒推荐了霍普菲尔德。霍普菲尔德1964年作为固体理论家加入普林斯顿时,惠勒是招聘委员会主任,此后也一直支持霍普菲尔德。惠勒思想开阔,对信息和物质的关系特别感兴趣,后来提出一个著名的口号“It from bit(物质来自信息)”,并成为量子信息最早的推动者。所以可以理解他对霍普菲尔德的支持。有趣的是,霍普菲尔德模型也关系到信息与物质的关系。

霍普菲尔德参加讨论组时,讲了细胞中分子合成的校正。讨论组里的神经科学家都是世界级专家,半年一次的会议给了他神经生物学的教育,被吸引到这个领域。

霍普菲尔德开始了对大脑的研究,他认为最深刻的问题是大脑中如何涌现出意识,但认为这组科学家虽然在生物学上富有天赋,却不可能解决这个问题,因为答案需要以适当的数学语言和结构描述。霍普菲尔德采取综合的观点,希望定义、构造或者发现对这个领域有用的东西,不拘泥于细节,找到一个理论物理工具可以处理的题目。当时有个热门领域是元胞自动机,每个元胞根据相邻元胞的状态迭代自己的状态。霍普菲尔德觉得可以修改Conway的“生命游戏”,作为大脑模型。1979年秋天开始研究。他需要做数值模拟,研究动力学轨迹和吸引子,但是普林斯顿和贝尔实验室的计算资源不够,所以进展不大。

1979年,在德尔布吕克(早年从理论物理学家转行成为生物学家)的努力下,加州理工学院正在加强生物与物理的联系,而新校长、普林斯顿物理系原主任Marvin Goldberger建议了霍普菲尔德。以他关于电子转移和动理学校正这两个工作为依据,加州理工聘请他为化学与生物学教授。霍普菲尔德回忆说,当时费曼和盖尔曼主导的物理系对这样的聘用没有兴趣。1980年,霍普菲尔德加入了加州理工。有意思的是,仅仅一年后,费曼就对计算表现了强烈兴趣(见下文),而多年后,盖尔曼也投身复杂性研究,与安德森及其他人推动成立圣塔菲研究所。

经过在加州理工的计算机上的尝试,霍普菲尔德发现元胞自动机模型不合适,改为接近神经网络的随机模型(联结随机),后来又改为接近生物神经系统情况的神经网络模型,即霍普菲尔德模型,展现了联想记忆,发现对称联结下的动力学吸引子,而且与自旋玻璃类似。正如霍普菲尔德回忆:“神经生物学与我所懂的物理系统突然有了一个联系(感谢与安德森的终身交流)。”

关于自旋玻璃的知识、计算资源,以及一点神经生物学知识导致了1982年的这篇文章。这篇文章将大脑活动看成计算,标题就是“具有层展合作计算能力的神经网络和物理系统“,吸引了很多物理学家和计算机科学家投身神经网络和神经科学,也是霍普菲尔德被引用最多的文章。

1981年至1983年,霍普菲尔德与费曼和Carver Mead合开过两次 “计算的物理学“一年课程,霍普菲尔德讲神经网络。费曼对量子计算感兴趣,霍普菲尔德强调计算中的纠错,可惜费曼没有在量子计算中对此重要问题感兴趣。课程还邀请客人来讲课,包括安德森。这个课程导致了”计算和神经系统“博士项目。1984年,安德森成为普林斯顿大学全职教授。1983年,费曼还将霍普菲尔德介绍给计算机专家Daniel Hillis,并帮助在后者的大型计算机“联结机”上编程实现霍普菲尔德神经网络。

霍普菲尔德在伯克利的学生包括Gerard Mahan和Bert I. Halperin。他在普林斯顿的学生包括徐绍达、Steven Girvin以及 Terry Sejnowski。他在加州理工的学生包括David Mackay,李兆平和Erik Winfree。Mahan、Halperin、徐绍达和Girvin都是著名凝聚态理论家。Mahan1967年关于金属x射线吸收的理论启发了上文提到的安德森的近藤效应工作;他的《多粒子物理(Many-particle Physics)》教科书影响很大。徐绍达毕业后是安德森的博士后,后来成为很多中国物理学家的老师或合作者。Sejnowski的博士论文是关于神经网络,说明Hopfield当时已经开始关注这个领域。李兆平1983年以第一名成绩从复旦大学考取CUSPEA,后来提出视觉初级皮层显著图假说。

1997年霍普菲尔德回到普林斯顿大学,但是在分子生物学系,因为这个系要发展神经生物学。系里同事都当他是物理学家,但是认为物理对于生物还是有用的。他2006年任美国物理学会主席,说明物理学界认可他的工作仍然是物理。

1985年,霍普菲尔德因为“富有想象力和预言性的理论物理工作,打开若干生物学新领域大门”,获美国物理学会的生物物理奖,报道提到他1960年代的血红蛋白工作,1970年代的细胞内分子合成的校正机制,1980年代的神经系统合作现象,以及与Tonk合作的神经元功能模型[39]。2002年,他因为计算神经科学和神经工程的成就,获得宾夕法尼亚大学Harold Pender奖;2005年,因为生命科学方面的贡献获爱因斯坦世界科学奖;2009年,因为生物系统信息处理方面贡献获IEEE的Frank Rosenblatt奖;2012年,获神经科学协会的Swartz奖;2019年,”因为用理论物理的概念给一系列领域的重要生物学问题提供新见解,包括神经科学和遗传学,对计算机科学的机器学习产生重要影响“,获富兰克林研究所的富兰克林物理奖;本文前面提到,他也获得了理论物理的狄拉克奖和统计物理的玻尔兹曼奖。

07

玻尔兹曼机

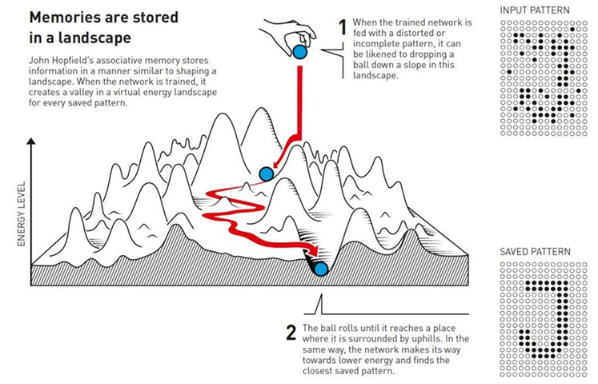

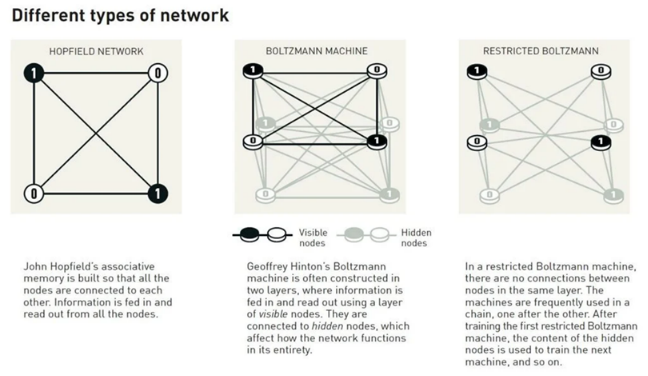

霍普菲尔德模型发表不久,在卡内基-梅隆大学,辛顿和T. Sejnowski等人提出一个随机性推广[40],使用统计物理的玻尔兹曼概率分布(系统不同状态的能量决定概率),发展了所谓玻尔兹曼机,

这里si 就是霍普菲尔德的符号Vi , T是描述玻尔兹曼分布的等效温度,wij 就是霍普菲尔德的符号Tij, θi 代表局域偏向。这两个参数使得模型生成模式的统计分布与训练所用模式偏离尽量小。从统计物理的角度,这可以看成霍普菲尔德模型的有限温度推广。他们还发展了基于梯度的学习算法来决定参数[41]。

玻尔兹曼机着重模式的分布,而不是单个模式,因此能够在数据中寻找特征。机器训练时,哺以运行时可能出现的例子。因此机器可以对图像进行分类,或者产生与训练所用例子同一类的图像。

玻尔兹曼机通常用两种节点,包括可见节点和隐藏节点。训练时,信息提供给可见节点,但隐藏节点也对能量函数有贡献,因此便于代表更一般的概率分布。在一定规则下,各节点的状态值不断更新,网络整体性质最终确定,虽然各节点的取值还在变化。各种位形出现的概率由玻尔兹曼概率分布决定。玻尔兹曼机是生成模型的一个早期例子。

玻尔兹曼机的训练也基于对联结的更新,使得运行时,曾被用作训练例子的信息出现概率高,它也能在没有见过的信息中辨认熟悉的元素。

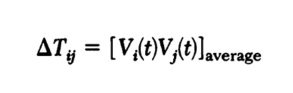

但是玻尔兹曼机的使用很有限,虽然理论上是有趣的。后来人们去掉某些联结,提高效率,即所谓的受限玻尔兹曼机(图4),其中同层节点之间没有联结。

图4 3种不同的网络,从左向右:霍普菲尔德网络、玻尔兹曼机、受限玻尔兹曼机。图源:文献[2]。

1980年代,前馈神经网络也取得进展。1986年,认知科学家David Rumelhart、Williams和作为计算机科学家的辛顿证明[42],可以用误差反向传播的学习算法,训练具有一层或多层隐藏层的前馈网络。隐藏层通过类似微积分中的链式法则将输入和输出层联系起来。这一年,Rumelhart还和James McClelland合作出版了一本联结主义著作《并行分配处理(Parallel Distributed Processing)》,包含反向传播算法。联结主义复活了。1990年代,人工神经网络再次进入低潮,但是辛顿坚持下来。

霍普菲尔德1982年最初的神经网络只有30个节点,435个联结,500个参数,后来达到100个节点。但是霍普菲尔德和辛顿的工作给2010年左右开始的机器学习革命打下了基础。

08

深度学习

深度学习是人工神经网络再次向神经科学学习的结果。1958年,Oliver Selfridge(Minsky尊他为师)猜想视觉神经元分等级,低级神经元连接光感受器,检验它接受的信号是否符合某种简单模板,高级神经元整合不同低级神经元的信息[43]。1959年,Jerome Lettvin,H. Maturana, McCulloch和Pitts证实了这个猜想,他们发现,青蛙的光感受器细胞将信息传给神经节细胞,不同的神经节对于空间区域有不同的选择,又负责识别不同的简单图形[44]。早年,Selfridge 、Lettvin与Pitts和McCulloch在芝加哥时期都是朋友,后来又都来到麻省理工学院,成为维纳的合作者。

1958至1968年,生物学家David Hubel和Torsten Wiesel详细研究了猫的视觉系统的信息处理过程,分享了1981年诺贝尔生理学或医学奖。下面按我的理解,简单介绍这个过程。详细情况可参阅饶毅的著作[45]。

光到达视网膜后,进入光感受器细胞,产生信号,传给视网膜神经节细胞(RGC),RGC产生动作电位,传给位于丘脑的外测膝状体(LGN),LGN再产生信号传给初级视觉皮层。每个RGC联系一定范围的光感受器细胞,叫做感受野,接受一定范围的光。

他们发现,初级视觉皮层上的每个神经元对应某个感受野,只对某个区域、某个方向的线条敏感。这叫简单细胞。对相同方向敏感的简单细胞排成一个功能柱,敏感区域逐步变化。相邻功能柱的敏感方向逐步变化。这种排列对应于LGN识别点的细胞排列。

在高级视觉皮层,有复杂细胞和超复杂细胞。复杂细胞整合来自一系列简单细胞的关于相同方向的信号,对某个方向的线条敏感,但对位置不敏感。超复杂细胞整个来自不同复杂细胞的信号。后来他们也研究了猴的视觉,情况类似。而且,神经科学家逐步认识到,哺乳动物的中枢神经系统分区,有视觉区、听觉区、体觉区、运动区等等。每个区的神经细胞联系相关的感觉器官,也有类似的等级结构和功能柱。

1960年代末,日本NHK的研究人员福岛邦彦从同事的报告中了解到Hubel和Wiesel的工作,于是在计算机模型中模仿视觉系统。他将图像分成一组网格,每个网格用数字代表里面的线条方向,这就是滤波。他还用一个人工神经元模仿丘脑,对图像的每个网格做出反应,再将信息传给神经网络。丘脑状态乘以每个网格的滤波,再对所有网格求和,就是卷积,作为神经网络中每个简单神经元的状态,模仿简单细胞。它对网格位置和线条方向都是敏感的。对于不同的简单神经元,采用不同的滤波函数。然后他又进一步引入复杂神经元,模仿复杂细胞,输入来自对应相同方向线条的简单神经元。再后来,他自己做了进一步的构建。将具有共同特性的复杂神经元状态输入到又一层的简单神经元,然后再汇集到又一层复杂神经元。如此等等。而且他还加入Hebb学习律,改变神经元之间的联结。最后,他的模型有3层简单和复杂神经元,用计算机生成的图像进行训练。这就是所谓的新认知方法[46]。

1987年,贝尔实验室的计算机科学家杨立昆(Yann Lecun)意识到福岛邦彦的方法可以用来解决很多视觉难题,但是学习律需要改变。他和合作者采用反向传播算法训练,如果出现分类错误,就修改所有的联结,使得错误不再可能再出现。这就是多层卷积神经网络[47,48]。1990年代,很多美国银行用此方法对支票上的签字进行分类。卷积神经网络需要大量数据进行训练。2012年,辛顿和合作者用65万个神经元组成的神经网络,经过李飞飞搜集的120万图像训练,赢得了ImageNet图像识别比赛。Hochreiter和Schmidhuber提出长短期记忆方法[49],这是处理序列数据的递归神经网络。

对深度多层网络进行训练的突破来自受限玻尔兹曼机,其中只有可见层和隐藏层之间有耦合(见图4)。2002年,对于受限玻尔兹曼机,辛顿和合作者提出一个叫对比发散的有效近似学习算法[50],使之比玻尔兹曼机快很多。2006年,他又与合作者发展了多层网络的预训练过程[51],用位于不同层的一系列受限玻尔兹曼机对网络进行预训练,这给了联结更好的开始点。预训练后,再用反向传播算法,进行整体参数微调,从而不需要对训练数据编号,就能找到结构,然后用反向算法对这些结构标号,实现了深度和密集的网络。这是深度学习的里程碑。后来人们用其他方法进行预训练。基于大量的数据训练、强大的计算机算力,今天的神经网络有很多层,叫做深度神经网络,它的训练就是深度学习。

物理学不仅提供了神经网络的方法,而且也是它的重要用户。神经网络可以对函数做准确的近似[52],因此用来拷贝物理模型,提供了一种新的计算方法,大大降低对计算资源的需求。比如针对材料不同相的能量和原子间力,训练深度学习结构,计算精度与第一性原理相媲美[53],并能预言相变[54]和热力学性质[55]。也可以对密度泛函理论进行机器学习[56]。对量子多体波函数进行机器学习,作为一种新的变分法,可以得到准确的基态和能量[57]。对于多标度、非线性复杂问题,例如气候,机器学习可以取代传统的子网格参数化[58,59]。

早在1990年代,高能物理实验就普遍使用神经网络处理数据。神经网络经过训练后,可以在海量探测数据中找出稀少的特定模式。希格斯粒子和顶夸克的发现都用到了这个方法。

在天文学和天体物理中,神经网络也已经广泛用于数据分析。例如,位于南极的“冰立方”中微子探测器获得的数据,借助神经网络,给出了银河系的中微子图;几年前,卷积神经网络开始用于寻找系外行星;事件视界望远镜在获得银河系中心黑洞的图像时,也使用了神经网络。

迄今,深度学习神经网络最杰出的科学成就是AlphaFold从氨基酸序列预言3维蛋白质结构[60]。在诺贝尔物理学奖的通俗介绍和科学背景介绍中,都提到这点,与第二天的诺贝尔化学奖无缝衔接。

深度神经网络并不追求复现人脑,不在意内部结构,而是模仿人类行为、追求效果。在天量数据、强大算力、越来越多的隐藏层和网络的加持,深度神经网络和机器学习深刻改变着人工智能、神经科学、整个科学研究以及社会的很多方面,包括日常生活,比如,图像、语音识别、医疗诊断,等等。

霍普菲尔德和辛顿在人工神经网络上做出了开创性工作,辛顿也将此方法拓展到深度和密集神经网络。他们的突破建立在物理科学的成就之上,开启了新的处理问题的方式,人类有了新的智力工具,对科学、技术和社会都有革命性影响。

09

物理学是什么

2021年和今年的诺贝尔奖包含了一个信息,即物理学的研究对象除了电子、原子等等组成的系统,也可以是其他单元组成的系统,比如大气、神经网络乃至计算。它们是复杂系统,即具有一个或多个方面的 “复杂“性质(多尺度、非线性、无序等等),与之最相关的物理学传统分支是统计物理,也可以看成凝聚态物理的延拓。统计物理原理和方法可以用到各种领域,可以是基本粒子,可以是天体和宇宙,可以是凝聚物质、高聚物、复杂流体(软物质),也可以是生命,还可以更进一步,不是大自然本来有的系统,而是人造乃至社会系统 。

关于单个神经元的结构和功能的研究类似于原子物理,McCulloch-Pitts规则将神经元简化为一个信息处理单元, Hebb学习律又将神经元的状态与联结关联起来,相当于找到了原子之间的有效相互作用(但是这里有状态对联结的反馈,这是原子系统所没有的,也显示了出现联想记忆和智能的条件)。对于原子组成的凝聚物质来说,宏观性质只与单个原子的少数性质有关,神经网络与单个神经元的关系也类似。

这就是统计物理和层展论的基本思想。大量单元组成的系统出现新的现象和新的规律,也就是层展。霍普菲尔德有意识地以层展论为指导,用统计物理方法拯救了神经网络,使之走出低潮,是层展论的主动实践。他采纳有限的规则,将联想记忆的概念进行可操作化,将计算过程归结为一个在崎岖景观上寻找能量最低的过程,说明简单组元构成的多体系统的计算性质和记忆行为,并架起与自旋玻璃理论的桥梁。辛顿将神经网络从记忆发展到解释。他的神经网络被称作玻尔兹曼机,因为用到了玻尔兹曼统计分布,也就是各种位形都有出现的概率。玻尔兹曼机进一步寻找整体最小,也就是用温度避免束缚在局域极小。所以神经网络和机器学习是统计物理和层展论的胜利,2024年物理诺奖宣告了这一点。

与霍普菲尔德的工作相关,Larry Abbot、上面提到的Sejnowski和Sompolinsky获得2024年大脑奖,因为对计算和理论神经科学的开创性贡献,以及对理解主宰大脑结构、动力学和认知及行为的涌现所作的贡献。可见一批物理学家对脑科学做出了实质性贡献。

目前人工智能的成功很大程度上是一个经验性的黑箱和强力硬算,还缺少理解,还有很多统计物理规律有待我们去发现,正如脑科学中也有很多规律有待我们从统计物理角度去研究。这也会导致人工智能和脑科学的进步。

人工神经网络与脑既有共性,又有不同。人工神经网络最初受到脑神经网络的启发,但是后来“放飞”了,并不要求在结构上模拟大脑,而是从某些效果和功能上去模拟和超越。不过,1985年,霍普菲尔德模型被T. Poggio和C. Koch用到视觉[61]。我曾经对细菌或细胞表面的受体提出一个类似霍普菲尔德神经网络的模型[62]。

视觉处理的原理启发了卷积神经网络,可见脑科学仍然有待人工神经网络去模仿和应用。在近年来人工智能大发展中,反向传播算法起了关键作用,但是这完全是设计出来的算法,与脑的工作原理无关。有神经科学家去检查脑神经网络是否用到了反向传播。这就好比准晶在实验室制备出来后,有人去找大自然中的准晶,还有人试图看看大脑里面有没有量子计算。

一个有趣的问题是, 除了与其他科学相同的应用,例如用于数据处理分析,如何用现在的人工神经网络和人工智能推动神经科学[63] 。我们想到一系列问题,除了MacCulloch-Pitts律和Hebb律,大脑的其他规律能否用到人工神经网络?如何模仿大脑工作原理以做到低能耗,高效率?大脑智能有没有不可计算的(比如彭罗斯的想法)?大脑还有很多需要我们的人工系统去学习。反过来,人工神经网络还有哪些特征是生物神经系统具有的?如何用人工神经网络更贴切地模拟脑神经网络?神经网络和生物网络也带来相应的数学和物理问题,例如李雅普诺夫函数的存在性和构造[64]。

神经网络体现了各学科携手共进。相对于传统学科主流,交叉领域汇集了背景不同而又有“跨界“兴趣的研究人员,成为突破各自学科传统的先驱。其中每个人的身份界定是根据其处理问题的方法以及所受的训练。比如,我们可以将物理学定义为物理学家做的研究,也就是说以物理学传统建立的提出问题解决问题的方式所做的研究。霍普菲尔德说过:“也许物理学最好简单定义为‘经过物理学训练的人做的事情‘(perhaps physics is best defined simply as ‘what those trained in physics do‘”[34]。从社会学的角度,研究非传统物理领域还能获得物理学领域的荣誉,单单物理学训练也许还不够,还需要通过传统物理研究取得物理学家身份,比如霍普菲尔德是在物理学功成名就后转换轨道的,他在从事生物物理和神经网络之前,已经获得凝聚态物理的最高奖巴克利奖,而现在的诺贝尔物理学奖认证了他关于神经网络的工作属于物理学。

物理学界有时将一些新方向培育好后独立出去,例如力学和分子生物学。力学是个特殊的存在。物理学的基础课程有它,经典力学是物理学的根,还原论还喜欢将其他物理归结于它。但是作为研究领域,力学相对独立于主流物理,一方面与工程技术密切相关,又与很多领域有交叉,比如生物力学,还有数学上很复杂的问题,比如流体力学中的湍流。但是力学成就一直没有获得诺贝尔物理学奖(很大程度上是因为20世纪物理学前沿被量子论和相对论主导)。例如,英国剑桥大学的泰勒(G. I. Taylor)是历史上重要的流体力学专家,对流体力学做出巨大贡献,以他命名的专业名词有二十来个,但是他一生无缘诺奖。他的母亲与这次获诺奖的辛顿的奶奶(也就是寒春的母亲)是姐妹,都是布尔的女儿。他也参加了研制原子弹的曼哈顿计划(和寒春同时在那里)。随着复杂系统被纳入诺贝尔物理学奖的范畴,我也希望流体力学(如湍流问题)也能被眷顾。

但是有时也有一些方向一直存在于物理学内,如复杂系统和生物物理(生物学界也有生物物理,与物理学界的生物物理有所不同,biophysics一般指前者,biological physics一般指后者),这有社会学的因素,也由于物理学界认为这里有新的物理等待发现。本次诺贝尔物理学奖是一个里程碑。以前有物理学家(或物理出身的研究人员)如Delbruck和Crick成功转行到生物学并获得诺奖,但都是得生理或医学奖。这次是物理学奖,说明他们虽然研究对象是生物系统,但是他们做的工作仍然被物理学界当作物理。

霍普菲尔德一直认为自己做的事情完全符合物理学的精神和范式,他不用研究对象来定义物理,而是认为,中心思想是世界是可以被理解的,可以将物体拆开,理解组分的相互关系,做实验,在此基础上,发展对其行为的定量理解。物理学是关于我们周围世界的一种观点,通过努力、智慧和一定的资源 可以以预言性定量化的方式理解。成为物理学家是是投身对这种理解的追求 做一名物理学家就是寻求这种理解。

中文“物理“很好地概况了physics是”物之理“。传统的物理学各分支主要是按照”物“来划分,例如粒子物理、核物理、原子分子物理、光物理、凝聚态物理、天体物理、宇宙学。在我们自己所处的尺度,很多学科里因素复杂,不被当作物理学主体,比如化学(物理)、生物(物理)、地球(物理)、大气(物理)。如果物理学原理直接用的多,就带上物理二字。

“物理“有”理“的一方面,它们更多地被当作基础理论和大学课程,比如相对论、量子力学、统计物理。如果数学用得比较多,也作为数学物理里面的方向。基本相互作用是一种物理,但是即使全部掌握,怎么搭建起这个多尺度的世界呢?所以存在另一种物理,就是统计物理和层展论。

其实很多物理学分支的研究对象也不是“自然”本来的,如果将“自然”理解成没有人干预情况下就存在的。比如凝聚态物理研究很多人为制造的材料,事实上大多数都是“人造“材料。这些材料(比如超导材料,二维材料,拓扑材料,超构材料,等等等等)里有很好的物理。如果后来在大自然找到类似的物理系统,大家反而觉得新奇,比如原子核中的配对、中子星内部可能存在的超导和超流,高能物理里面的对称破缺(类似超导),等等。量子计算更是人为设计一个系统来实现理论上的量子算法。。

天体物理、大气物理、地球物理反而是研究大自然。但是它们因素复杂,更多地被看作物理的应用(虽然不是实用的应用)。而人工系统反而可以突出某个物理原理。费曼提出量子计算和量子模拟,其实就是为了更方便地研究“理“。

所以“传统”领域的物理虽然重视“物“,精髓还是在于”理“,而且有些研究方向的合法性就是在于研究”理“。甚至还可以先有“理“,再去寻找合适的”物“来实现。比如寻找实现非阿贝尔任意子的材料、实现任意子的编织操作、实现量子算法,等等,都是这一类的研究。

研究人工神经网络、细胞、生物种群、人群、交通流、经济学等所谓复杂系统中的统计物理,与研究量子模拟的逻辑是类似的。不过,量子模拟所用的系统大多是简单系统,直接由原子、电子、组成,也有复杂一点的,比如超导量子比特,由一个超导回路实现一个量子比特,探索中的拓扑量子计算更复杂。用于电磁波调制的超构材料是一种人造结构,尺度更大。由于人也是大自然的一部分,“人造“系统其实也是”自然“的。

工欲善其事,必先利其器。人们将设计建造探测和实验装置以及发展实验方法视作相应学科的一部分,事实上确实是至关重要的。这方面获得诺贝尔物理学奖的有:Albert A. Michelson因为发明光学精密仪器(即迈克耳孙干涉仪)并借此进行光谱和度量学研究,1907年获奖;Charles Edouard Guillaume发现镍钢合金反常可以用于精密测量,1920年获奖;C.T.R. Wilson因为发明通过水汽凝结显示带电粒子径迹的方法,1927年获奖;Ernest Lawrence因为发明回旋加速器以及以此取得的研究结果,特别是有关人工放射元素的结果,1939年获奖;Otto Stern因为分子束方法以及质子自旋的发现,1943年获奖;Percy W. Bridgeman因为发明产生极高压的装置并取得发现,1946年获奖;Patrick Blacket因为发展了Wilson云雾室并取得发现,1948年获奖;Cecil Powell因为发展研究核过程的照相方法并取得发现,1950年获奖;Felix Bolch和E. M. Purcell因为核磁精密测量的新方法并取得发现,1952年获奖;Walther Bothe因为符合方法并取得发现,1954年获奖;Donald A. Glaser因为发明气泡室,1960年获奖;Alfred Kastler因为研究原子赫兹共振的光学方法,1966年获奖;Luis Alvarez因为基于发展氢气泡室的技术和数据分析,发现大量共振态,1968年获奖;Dennis Gabor因为发明全息方法,1971年获奖;Martin Ryle因为射电天体物理的发现和发明,特别是孔径合成技术,1974年获奖;Pyotr Kapitsa因为低温物理的发明和发现,1978年获奖;Nicolaas Bloembergen和Arthur Schawlow因为激光光谱,Kai M. Sirgbahn因为高分辨电子谱,1981年获奖;Ernst Ruska因为电子光学的基础工作和设计第一个电子显微镜,Gerd Binnig和Heinrich Rohre因为设计扫描隧道显微镜,1986年获奖;Leon M. Ledermann, Melvin Schwartz和Jack Steinberger因为中微子束方法和缪中微子发现,1988年获奖;Norman Ramsey因为发明分离振荡场方法并用于氢脉塞和其他原子钟, Hans Dehmelt和Wolfgang Paul因为发展离子阱技术,1989年获奖;George Charpak因为发明和发展粒子探测器,特别是多丝正比室,1992年获奖;Bertram N. Brockhouse因为发展中子谱,Clifford Shull因为发展中子散射技术,1994年获奖;朱棣文、Claude Cohen-Tannoudji和William D. Philips 因为发展激光冷却和束缚原子的方法,1997年获奖;John L. Hall和Theodor W. Hänsch因为发展基于激光的精密谱,包括光频梳技术,2005年获奖;高锟因为光纤,Willard S. Boyle和George E. Smith因为发明CCD,2009年获奖;Serge Haroche和 David J. Wineland 因为测量和调控单量子系统的实验方法,2012年获奖;Isamu Akasaki, Hiroshi Amano 和 Shuji Nakamura因为蓝光发光二极管的发明,2014年获奖;Rainer Weiss, Barry C. Barish和 Kip S. Thorne因为对LIGO探测器的贡献并观测到引力波,2017年获奖;Arthur Ashkin因为光镊并用于生物系统,Gérard Mourou和Donna Strickland因为产生高强度超短光学脉冲的方法,2018年获奖;Pierre Agostini, Ferenc Krausz和Anne L’Huillier因为产生阿秒光脉冲的方法,2023年获奖。

化学奖和生理学或医学奖与此类似,例如:Carl Bosch 和 Friedrich Bergius因为发明和发展化学高压方法,1931年获奖;Archer J.P. Martin 和 Richard L.M. Synge因为发明分配色谱,1952年获奖;Willard F. Libby因为碳14方法用于考古、地质、地球物理等科学领域,1960年获奖;Richard R. Ernst Richard R. Ernst因为高分辨核磁共振谱,1991年获奖;Ahmed Zewail因为用飞秒光谱研究化学反应,1999年获奖;Eric Betzig, Stefan W. Hell 和 William E. Moerner因为发展超分辨荧光显微镜,2014年获奖;acques Dubochet, Joachim Frank 和Richard Henderson 因为发明用于高分辨地决定生物分子结构的冷冻电子显微镜,2017年获奖。

再提两个获得诺贝尔化学奖的计算成就:John Pople因为量子化学的计算方法,1998年获奖;Martin Karplus, Michael Levitt和Arieh Warshel因为发展复杂化学反应的多尺度模型,2013年获奖。

这样来看,作为科学研究的工具也可以获得诺贝尔科学奖。而且,计算物理早已与实验物理和理论物理共同成为物理学的三个方面。从计算科学的角度,用人工智能作为计算工具,取得科学进展,比如预言蛋白质结构,也可以授予诺贝尔奖。所以人工智能的科学应用、人工智能的科学基础都在诺贝尔奖的范围中。

还原论和层展论是一体两面,还原是层展的前提,给物理学带来了辉煌。层展不是仅出现于宏观尺度,而是出现在所有能量尺度。高能物理中的自发对称破缺和真空结构与它们的凝聚态兄弟一样,也是层展现象。宇宙多个尺度的结构形成也是层展现象,更无需说生命和智能的出现和进化。从原子论到基本粒子,还原论给物理学带来了辉煌。但是物理学即使在基本相互作用和基本粒子上暂时进展缓慢,在层展论方面仍然大有所为。

总之,物理学不但继续存在,而且还以各种新的方式更广泛地存在。借用希尔伯特的话说:

我们必须知道,我们终将知道(Wir mussen wissen. Wir werden wissen)。

参考文献:

[1] The Royal Swedish Academy of Sciences, The Nobel Prize in Physics 2024: Press Release, https://www.nobelprize.org

[2] The Royal Swedish Academy of Sciences, The Nobel Prize in Physics 2024: Popular Science Background, https://www.nobelprize.org

[3] The Nobel Committee for Physics, Scientific Background to the Nobel Prize in Physics 20242024 Nobel Prize in Physics, https://www.nobelprize.org

[4] J. J. Hopfield, Proc. Natl. Acad. Sci. USA 79, 2554 (1982).

[5] S.E. Fahlman, G.E. Hinton and T.J. Sejnowski. In Proceedings of the AAAI-83 conference, pp. 109-113 (1983).

[6] D.H. Ackley, G.E. Hinton and T.J. Sejnowski, Cogn. Sci. 9, 147 (1985).

[7] 施郁. 物理诺奖的科学哲学突破:从彭罗斯和霍金说起,知识分子,2020年10月23日.

[8] W.S. McCulloch and W. Pitts, Bull. Math. Biophys. 5, 115 (1943).

[9] D.O. Hebb, The organization of behavior (Wiley & Sons, New York, 1949).

[10] J. Konorski, Conditioned reflexes and neuron organization (Cambridge University Press, 1948).

[11] Ya-Ping Tang, Eiji Shimizu, Gilles R. Dube, Claire Rampon, Geoffrey A. Kerchner, Min Zhuo, Guosong Liu & Joe Z. Tsien, Nature volume 401, pages63–69 (1999)

[12] F. Rosenblatt, Principles of neurodynamics: Perceptrons and theory of brain mechanisms (Spartan Book, Washington D.C., 1962).

[13] M.L. Minsky and S.A. Papert, Perceptrons: An introduction to computational geometry (MIT Press, Cambridge, 1969).

[14] D. Willshaw, O. Buneman和H. Longuet-Higgins, Nature 222, 960 (1969); T. Kohonen, Associative Memory, (Springer, 1978); T. Kohonen, Content-Addressable Memories, (Springer, 1980).

[15] B. G. Cragg and H.N.V. Temperley, Brain 78, 304 (1955).

[16] E.R. Caianiello, J. Theor. Biol. 2, 204 (1961).

[17] K. Nakano, IEEE Trans., Syst., Man, Cybern. SMC-2, 380 (1972).

[18] S.-I. Amari, IEEE Trans. Comput. C-21, 1197 (1972).

[19] W. A. Little, Math. Biosci. 19, 101 (1974).

[20] W. A. Little and G. L. Shaw, Math. Biosci. 39, 281 (1978).

[21] 施郁, 物理学之美:杨振宁的科学贡献,低温物理学报,44 (1),1-32 (2022).

[22] B. Lundqvist, S. Lundqvist (eds), Proceedings of the Nobel Symposium on Collective Properties of Physical Systems, (Academic, New York).

[23] E. L. Bienenstock, Leon Cooper, Paul Munro, Theory for the development of neuron selectivity: orientation specificity and binocular interaction in visual cortex, The Journal of Neuroscience. 2 (1): 32–48 (1982);M. F. Bear, L. N. Cooper, and F. F. Ebner, A Physiological Basis for a Theory of Synapse Modification, Science 237, 42 (1987).

[24] D. Krotov and J. J. Hopfield. In Advances in Neural Information Processing Systems 29, 1172 (2016).

[25] D. J. Amit, H. Gutfreund and H. Sompolinsky, Phys. Rev. A 32, 1007 (1985).

[26] M. Mézard, G. Parisi and M. Virasoro, Spin glass theory and beyond: An introduction to the replica method and its applications (World Scientific, Singapore, 1987).

[27] J.J. Hopfield, Proc. Natl. Acad. Sci. USA 81, 3088 (1984).

[28] J.J. Hopfield and D.W. Tank, Biol. Cybern. 52, 141 (1985).

[29] J.J. Hopfield and D.W. Tank, Science 233, 625 (1986).

[30] J. J. Hopfield, Neurons, Dynamics and Computation, Physics Today. 47 (2): 40–46 (1994).

[31] J. J. Hopfield and A. V. Herz, Rapid local synchronization of action potentials: toward computation with coupled integrate-and-fire neurons. Proceedings of the National Academy of Sciences. 92 (15): 6655–6662, 11995 (1995).

[32] P. Bak, C. Tang, K. Wiesenfeld, Phys. Rev. Lett. 59(4), 381 (1987).

[33] J.J. Hopfield, Whatever Happened to Solid State Physics? Annual Review of Condensed Matter Physics. 5 (1): 1–13 (2014)。

[34] J.J. Hopfield, Now What? 2019.10.

[35] P. W. Anderson,A Career in Theoretical Physics , World Scientific, Singapore, 1994.

[36] 施郁. 层展论的旗手——菲利普•安德森,自然杂志,2021, Vol. 43 (1): 71-80 .

[37] P. W. Anderson, More Is Different: Broken symmetry and the nature of the hierarchical structure of science. Science, 1972, 177 (4047): 393-396.

[38] A. Zangwill, A Mind Over Matter: Philip Anderson and the Physics of the Very Many (Oxford University Press, Oxford, 2021).

[39] "American Physical Society Meets in Baltimore". Physics Today. 38 (3): 87–93. March 1, 1985.

[40] S.E. Fahlman, G.E. Hinton and T.J. Sejnowski. In Proceedings of the AAAI-83 conference, pp. 109-113 (1983).

[41] D.H. Ackley, G.E. Hinton and T.J. Sejnowski, Cogn. Sci. 9, 147 (1985).

[42] D.E. Rumelhart, G.E. Hinton and R.J. Williams, Nature 323, 533 (1986).

[43] G. Lindsay, Grace. Models of the Mind: How Physics, Engineering and Mathematics Have Shaped Our Understanding of the Brain (Bloomsbury Publishing,2021).

[44] Lettvin, J.Y; Maturana, H.R.; McCulloch, W.S.; Pitts, W.H., What the Frog's Eye Tells the Frog's Brain, Proceedings of the IRE, Vol. 47, No. 11, November 1959.

[45] 饶毅, 生物学概念与途径, 11(下):整合, 饶议科学, 2022年06月16日.

[46] K. Fukushima, Biol. Cybern. 36, 193 (1980).

[47] Y. LeCun, B.Boser, J.S. Denker, D. Henderson, R.E. Howard, W. Hubbard and L.D. Jackel, Neural Comput. 1, 541 (1989).

[48] Y. LeCun, L. Bottou, Y. Bengio and P. Haffner, Proc. IEEE 86, 2278 (1998).

[49] S. Hochreiter and J. Schmidhuber, Neural Comput. 9, 1735 (1997).

[50] G.E. Hinton, Neural Comput. 14, 1771 (2002).

[51] G.E. Hinton, S. Osindero and Y.-W. Teh, Neural Comput. 18, 1527 (2006).

[52] K. Hornik, Neural Netw. 4, 251 (1991).

[53] J. Behler and M. Parrinello, Phys. Rev. Lett. 98, 146401 (2007).

[54] R. Jinnouchi, J. Lahnsteiner, F. Karsai, G. Kresse and M. Bokdam, Phys. Rev. Lett. 122, 225701 (2019).

[55] P.M. de Hijes, C. Dellago, R. Jinnouchi, B. Schmiedmayer and G. Kresse, J. Chem. Phys. 160, 114107 (2024).

[56] P.M. Piaggi, J. Weis, A.Z. Panagiotopoulos, P.G. Debenedetti and R. Car, Proc. Natl. Acad. Sci. USA 119, e2207294119 (2022).

[57] G. Carleo and M. Troyer, Science 355, 602 (2017).

[58] S. Rasp, M.S. Pritchard and P. Gentine, Proc. Natl. Acad. Sci USA 115, 9684 (2018).

[59] C. Wong, Nature 628, 710 (2024).

[60] J. Jumper et al., Nature 596, 583 (2021).

[61] T. Poggio and C. Koch, Ill-Posed Problems in Early Vision: From Computational Theory to Analogue Networks, Proc. R. Soc. Lond. B 226, 303-323 (1985).

[62] Y. Shi and T. Duke, Cooperative Model of Bacterial Sensing, Phys. Rev. E 58, 6399-6406 (1998).

[63] Z. Li, Artificial and Natural Intelligence: From Invention to Discovery 105, 413-415, (2020).

[64] J. J. Hopfield,Brain, neural networks, and computation,Rev. Mod. Phys. 71, S431-437 (1999); C. Kwon, P. Ao, D. Thouless, Structure of Stochastic Dynamics near Fixed Points, Proc. Natl. Acad. Sci. 102 (37), 13029-13033 (2005).